Роботов все чаще используют в различных интерактивных сценариях для помощи людям, при этом их наделяют антропоморфными чертами, в том числе признаками половой принадлежности. Так, в роботах, которые помогают учителям в школах и детских садах, используютженский голос. В этом и ряде других случаев наделение робота половыми признаками помогает людям привыкнуть к нему. Однако некоторые исследователи предупреждают, что такой подход может усугубить гендерные стереотипы в общественном мнении.

Исследователи уже проверяли, влияет ли на доверие к домашнему роботу, который выполнял функции сиделки или охранника, его гендерная принадлежность. Участники эксперимента действительно предпочитали роботов, чей пол соответствовал социальному стереотипу для того или иного рода деятельности (охраной в основном занимаются мужчины, а сиделками чаще бывают женщины). Однако на доверие к способности робота выполнять свои функции его пол не влиял.

Эянна Ховард (Ayanna Howard) и ее коллеги из Технологического института Джорджии выяснили, влияет ли пол робота на веру в его компетентность в разных задачах. Для начала провели предварительный опрос среди 50 добровольцев. Их спрашивали, люди какого пола обычно ассоциируются с различными профессиями. Для эксперимента выбрали те роды деятельности, гендерную специфичность которых признавали более 60 процентов участников.

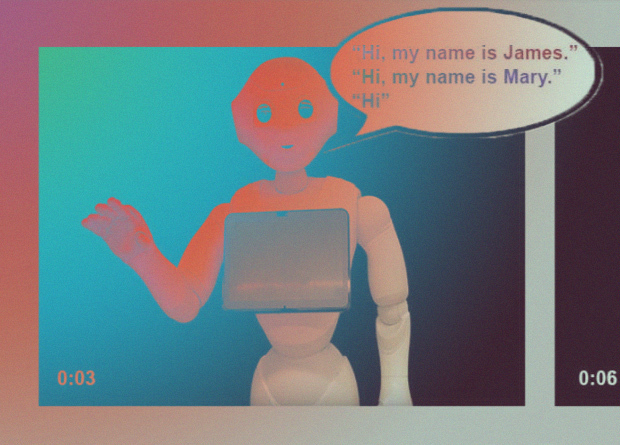

На второй стадии 150 добровольцам показывали видео, в котором внешне гендерно-нейтральный гуманоидный робот Pepper здоровался, называл свое имя (Мэри или Джеймс) и рассказывал, что он умеет выполнять множество задач, женскими или мужским голосом. В контрольных записях робот не называл свое имя и говорил голосом, по которому было невозможно определить пол.

После просмотра видео участники заполняли два опросника про способность робота выполнять профессии, которые отобрали в предварительном эксперименте. Добровольцы отвечали на два вопроса: «Насколько вероятно, что робот может выполнять задачи, необходимые для следующей профессии?» и «Насколько вы доверили бы роботу выполнение задач, необходимых для следующей профессии?». Ответить необходимо было по пятибальной шкале, где 1 — крайне маловероятно/абсолютно не доверяю, а 5 — очень вероятно/полностью доверяю.

Следующие профессии большинство участников ассоциировало с женским полом: сиделка, няня, медсестра, регистратор, официант, учитель и терапевт. Мужскими же посчитали профессии комика, пожарного, курьера, охранника и хирурга; не связанными с полом назвали профессии ведущего новостей и гида.

По мнению участников роботы могли бы выполнять необходимые задачи лишь в половине профессий: сиделки, ведущего новостей, курьера, регистратора, официанта, учителя и экскурсовода. В остальных случаях добровольцы сомневались в компетентности машины. Пол робота не влиял на оценку компетентности и доверия к выполнению задач, которые связаны с перечисленными профессиями. Совпадение пола робота с полом опрашиваемого тоже не повлияло на ответ. Зато то, насколько люди доверили бы люди выполнение профессии роботу, в большинстве случаев зависело от того, считали ли участники механизм в целом способным выполнять соответствующие задачи. Значит, на доверие к роботу влияет не гендерная принадлежность, а субъективно оцениваемая компетентность.

Авторы работы отмечают, что раз пол не влияет на доверие к компетентности роботов, стоит делать их гендерно-нейтральными, чтобы не укреплять в обществе гендерные стереотипы.

Человеческие стереотипы передаются и роботам, ведь многие алгоритмы обучаются на текстах, которые могут содержать признаки, к примеру, сексизма или расизма. Ученые доказали, что алгоритмы машинного обучения перенимают человеческие стереотипы и привели пример сексизма в переводчике Google Translate.

Комментарии:

Авторизуйтесь, чтобы оставить отзыв